| 导读 | OpenAI已经建立了一个名为MuseNet的新的深度神经网络来编写音乐,其细节在博客文章中分享。 该研究机构已经制作了一个MuseNet驱动的共同作曲家的原型,供用户试用到5月12日。 |

OpenAI推出MuseNet:一种用于生成音乐作品的深层神经网络

MuseNet使用与OpenAI的GPT-2语言模型Sparse Transformer相同的通用无监督技术。该变换器允许MuseNet根据给定的音符组预测下一个音符。为了启用此行为,Sparse Transformer使用称为“稀疏注意”的内容,其中每个输出位置都根据输入位置的子集计算权重。

对于音频片段,使用稀疏变换器的重新计算和优化内核训练具有24个注意力头((attention head))的72层网络。这提供了模型的长上下文,使其能够记住一个片段中的长期结构。

为了训练模型,研究人员收集了各种来源的训练数据。数据集包括ClassicalArchives和BitMidi捐赠的MIDI文件。该数据集还包括来自在线收藏的数据,包括爵士,流行,非洲,印度和阿拉伯风格。

该模型能够用10种不同的乐器制作4分钟的音乐作品,并且能够从巴赫,莫扎特,披头士乐队等作曲家那里了解不同的音乐风格。它还可以令人信服地融合不同的音乐风格,以创造一个全新的音乐作品。

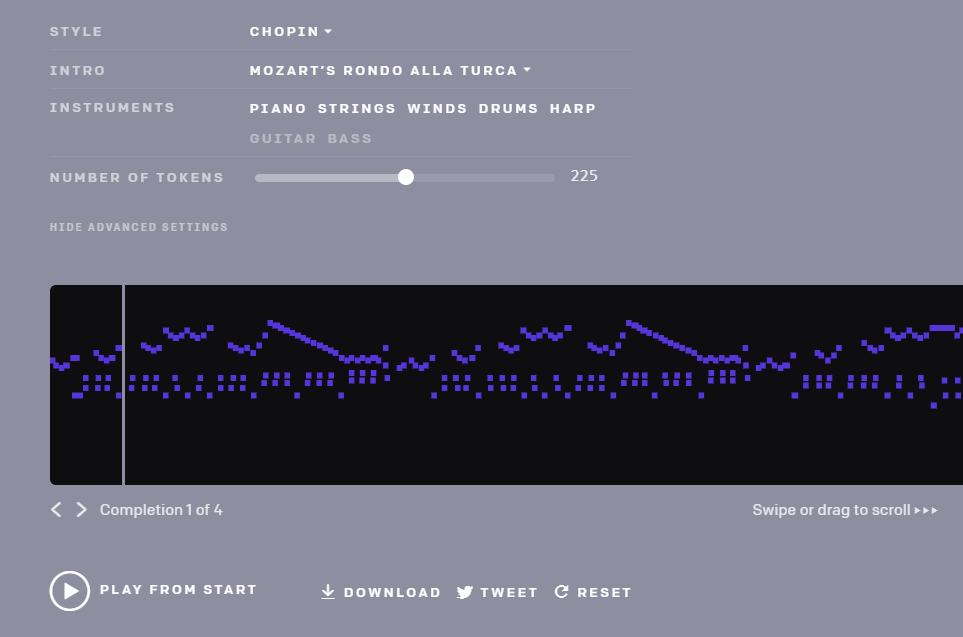

MuseNet原型可供用户试用,只有一小部分选项。它支持两种模式:

在简单模式下,用户可以收听OpenAI生成的未经验证的样本。 要自己制作一首乐曲,你只需要选择一个作曲家或风格和一个著名作品的可选开头。

在高级模式下,用户可以直接与模型进行交互。 在这种模式下生成音乐需要更长的时间,但会产生一个全新的作品。

音乐生成工具仍然是原型,所以它确实有一些局限性:

要生成每个音符,MuseNet会计算所有可能音符和乐器的概率。虽然该模型更优先考虑您的乐器选择,但它可能会选择其他内容。

MuseNet发现在奇怪的风格和乐器配对的情况下难以生成乐曲。如果您选择最接近作曲家或乐队常用风格的乐器,生成的音乐听起来会更自然。

许多用户已经开始测试该模型。虽然一些用户对AI产生的音乐印象深刻,但有些人认为很明显音乐是机器生成的并且缺乏情感因素。

虽然这个模型处于早期阶段,但是一个重要的问题是谁将拥有所生成的音乐。

原文来自:https://www.linuxidc.com/Linux/2019-04/158331.htm

本文地址:https://www.linuxprobe.com/linux-openai-musenet.html编辑:向金平,审核员:逄增宝

Linux命令大全:https://www.linuxcool.com/

Linux系统大全:https://www.linuxdown.com/

红帽认证RHCE考试心得:https://www.rhce.net/